どんな撮影に向いてるの...?

「Deep Fusion」は、iPhone 11をiOS 13.2にアップグレードすると追加される新機能。iPhone 11 Pro でベータ版を数週間使用してみたという米Gizmodoメンバーいわく「Deep Fusionは使える!ただし、特殊な場所での撮影に限る」とのこと。具体的にどんな機能なのでしょうか……彼によるレビューをご覧ください。

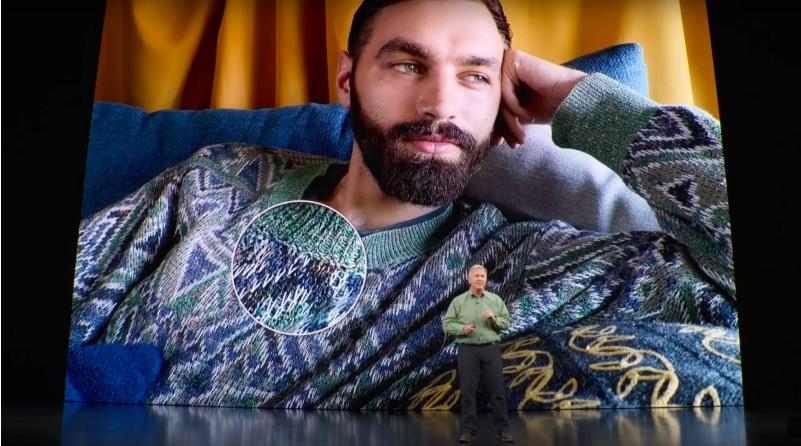

まず最初に抑えておきたいのが、Apple社にとってDeep Fusionはイチオシの機能であること。9月のイベントでも、Deep Fusionが「ニューラルエンジンが初めて画像出力を生成した」ものであることを数分かけてじっくり説明していました。

Deep Fusionは、「A13 Bionic」チップのニューラルエンジンが画像ピクセルを最大限に引き出すことで、ノイズを減らし、よりディテールが細かい写真に仕上げてくれるのだそうです。

そこまで複雑なプロセスではないのでもうちょっと詳しく説明すると、オールドスクールな手法で、1枚の写真を複数の設定で撮影するブラケット撮影というものがあります。これと類似して、iPhoneのカメラはシャッターボタンを押す前に、4つの短時間露光フレームと4つの標準露光フレームを捉えます。 (そのためiPhoneのカメラは、Deep FusionやSmart HDR撮影に備えてアプリが開いているあいだは常にバッファーフレームを捉えていることになります。)この状態でシャッターを押すと、カメラはさらにディテールを映し出す1つの長時間露出を捉えます。

こうしてディテールが反映された短時間露光フレームと、標準露光ショットと長時間露光を組み合わせたものとして2つのインプットができます。さらにニューラルネットワークで4つの異なる周波数帯域から分析されて、各画像からノイズが除去され、最終的には2つのインプットがピクセルごとに融合されるようになっています。

説明すると長いですが、実際に一連のプロセスにかかる時間は約1秒。また、その間に引き続き撮影を続けることもできるので待ち時間はもちろんゼロです。

Deep Fusionについて知るほど、なんとなく昨年iPhone XSで登場したSmart HDR機能とカブるなぁーなんて思った人もいるかもしれません。理論的には、撮影ラグを防ぐためバッファイメージを常に捉えているという点では同様です。ただ実際のところ、Deep Fusionはあらゆる露出のハイライトとシャドウを引き出して、より詳細なところまでキャプチャするだけではないんです。失われた可能性のある詳細までをもキープするべく、個々のフレームがかなり詳細なレベルで機能しているのです。

ここからは、Deep Fusionでできること・できないことを見てみましょう。

たとえば、Deep FusionはiPhoneの超広角カメラ(Ultra Wide camera)では使えません。が、ワイドカメラの低光〜中程度の光であれば使えます。かなり明るい場所を除けば、テレフォトカメラでも使用できます。また、カメラアプリ設定画面の「構成」の下にある「写真のフレームの外側を含めて撮影」をオンにすると、Deep Fusionが使用できないので注意。

さて、ここからは実際にiOS 13.2でDeep Fusionベータ版を社用のiPhone 11 Proにダウンロードして使ってみた話を。いろいろな場所に行って撮影し、自分のiPhone 11 Pro(旧iOSバージョン。Deep Fusionなし)で撮影した画像と比較してみました。

あらかじめ、正直に言っておきます。どちらで撮影したものも良かったのですが、大きな違いがあったかというと、そうでもありません。どうか皆さんの目でも、Deep Fusionで撮影したものと普通に撮影したものを見比べてみてください。

どうでしょう? まず注目したいのが、時計の数字部分。Deep Fusionアリ(右)のほうがわずかながら鮮明に見えませんか? あとはよく見ると国旗のさざ波の打ち加減、さらには石柱もノイズが少ないのがわかります。

撮影が行なわれたニューヨークのグランドセントラル駅のメインコンコースは薄暗くで、夕暮れ時に撮影されたことも踏まえるとどちらも明るく鮮やかな画像に仕上がっています。差は微々たるものですが、Deep Fusionアリ(右)のほうがすこしばかり良い写真だと言えるでしょう。

次の写真は、雨で暗い日に撮影したマンハッタンのミッドタウンにある高層ビルをズームインしたものです。

こう並べると難易度マックスの間違い探しゲームのように、もはやどこがどう違うのかわからなくなりそうですが、ひとつだけ共感してもらえるかもしれないところを発見しました。縦横に走る白いラインがDeep Fusionアリ(右)だとわずかに白く、ナシ(左)のほうは霞んで見えませんか? それからDeep Fusionアリ(右)のほうが全体的にノイズが除去されていて、窓の反射も鮮明に見えます。

ここまででDeep Fusionを実際に使ってみて思ったことは、主にふたつあります。一連の比較画像のとおり、どちらのカメラで撮影しても高い画像クオリティを期待できること。そして、場合によってはDeep Fusionアリのほうがわずかにベターな画像を追及できることもあるということ。

では、Deep Fusionはどんな撮影に向いているのでしょうか…?

その答えは、Appleがイベントで使用した画像(記事の上から2枚目参照)にある、セーターを着用したヒゲの男性にありました。ずばり、毛です。

…というわけで、ふかふか毛布でお休み中の愛犬ピーナッツちゃんを撮ってみました。どちらの画像でもまるで天使のように可愛いですよね。でも、画像を見比べると顔周りの特に耳のあたりの毛並みがDeep Fusionアリ(右)だとより鮮やかに写っているのがわかります。今回は特別に、もっと近くで見てみましょう。

Deep Fusionナシ(左)のほうは、どこにもフォーカスされていないのがわかります。これからピーナッツを撮影するときは、Deep Fusionナシなんてもはや邪道に思えてきました...!

でも、ここでふと思ったのです。Deep Fusionが使える機会はこうも限られているのに、Appleはどうして9月のiPhone発表イベントで大々的にDeep Fusionへの注目を集めたのか...? それからリリースまでに数ヶ月かけたのは何故なのか...?

おそらくですが、Deep FusionはAppleがこれまでに作ったなかで最高傑作のテクノロジーのひとつなのかもしれません。もしかすると現段階で使えるのはその一部で、もっと将来的には私たちをワッと言わせる機能が開発されているのかも...?

Google Pixel 4のズーム機能で「Super Res Zoom(超解像ズーム)」では、光学ズームとデジタルズームを組み合わせて、超シャープなズームショットを提供しています。iPhoneで背面カメラが3台搭載されるようになったいま、Appleがズーム機能の改善を模索している可能性も考えられますね。(あくまで推測ですけどね。)

iPhone 11またはiPhone 11 ProユーザーでDeep Fusion機能を利用するには、iOS 13.2へのアップグレードが必要になります。ただ、いまの段階でDeep Fusionがマルチに役立つわけではないことを鑑みると、iPhone 11またはiPhone 11 Proユーザー以外はDeep Fusionのみを理由にアップグレードするのは避けたほうが良いかもしれません。もしかすると、翌年以降にもっと大きなものが待っている可能性もありますからね。

最後にもうひとつだけ強調しておきます。iPhone 11、iPhone 11 Proのカメラは本当に良きです。個人的には今年から新たに登場した超広角カメラ(Ultra Wide camera)機能がお気に入りなので、最後にこの画像で締めておきます。